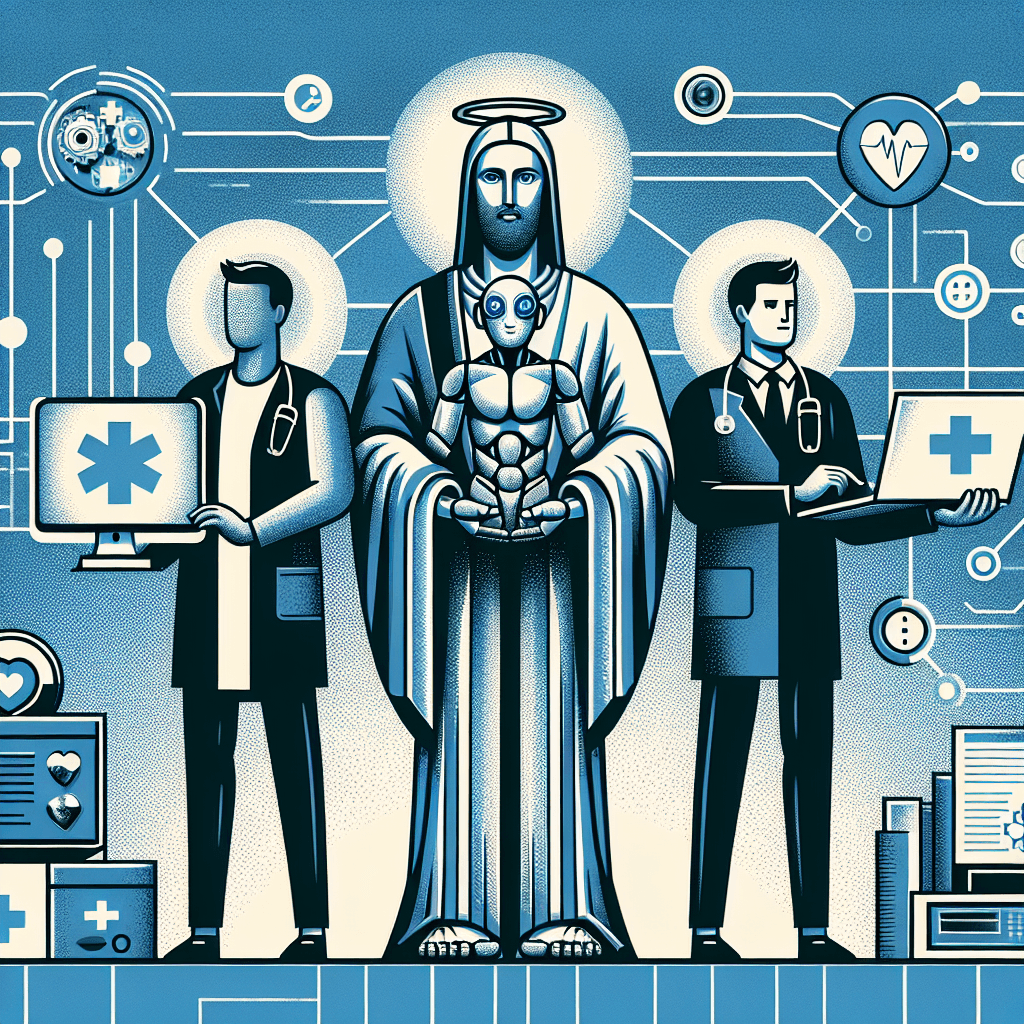

El papa León XIV: la IA, una ayuda en sanidad pero no un sustituto del médico

Resumen de la declaración y contexto inmediato

En la conferencia de la Confederación Médica Latinoiberoamericana y del Caribe (CONFEMEL), celebrada en el Vaticano el 1 de octubre, el papa León XIV se pronunció sobre el uso de la inteligencia artificial (IA) en la medicina. Según su intervención, la IA «puede y debe ser una gran ayuda para mejorar la asistencia clínica, pero nunca podrá ocupar el lugar del médico». Añadió que el diálogo, la comunicación y el contacto físico son elementos esenciales de la relación terapéutica y que una IA «nunca podrá tener un gesto de cercanía o una palabra de consuelo».

«El uso de la inteligencia artificial en medicina puede y debe ser una gran ayuda para mejorar la asistencia clínica, pero nunca podrá ocupar el lugar [del] médico».

Por qué importa: la tensión entre eficiencia tecnológica y relación clínica

La intervención del papa se produce en un momento de rápido despliegue de soluciones de IA en salud y de debates públicos sobre hasta qué punto estas tecnologías pueden sustituir tareas humanas. Figuras públicas como Bill Gates han planteado que, con el avance de la IA, la intervención humana podría dejar de ser necesaria en algunos aspectos del diagnóstico. Por su parte, especialistas como el catedrático Julio Mayol han afirmado que herramientas basadas en modelos de lenguaje (por ejemplo, GPT-4) y otras IAs podrían terminar por sustituir a ciertos profesionales sanitarios en algunas funciones.

El asunto trasciende la retórica: la adopción de algoritmos de apoyo al diagnóstico, sistemas de priorización de pacientes y asistentes virtuales ya está cambiando flujos asistenciales. La discusión no es solo técnica sino ético-profesional y regulatoria: ¿qué partes del proceso asistencial deben permanecer bajo supervisión humana directa? ¿Cómo garantizar calidad, equidad y responsabilidad cuando la IA participa en decisiones que afectan a la salud?

Limitaciones y riesgos técnicos que sustentan el argumento del papa

Desde la perspectiva clínica y técnica existen razones objetivas para mantener la supervisión humana:

- Empatía y relación paciente-médico: el contacto físico, la escucha activa y las habilidades de comunicación forman parte integral del diagnóstico y del tratamiento, especialmente en enfermedades crónicas, salud mental y cuidados paliativos.

- Explicabilidad y confianza: muchos modelos de IA son cajas negras. En medicina se requiere comprender por qué se toma una decisión para validarla y para informar al paciente.

- Calidad de datos y sesgos: los algoritmos son tan buenos como los datos con los que se entrenan. Historias clínicas incompletas o datos no representativos pueden producir recomendaciones erróneas o discriminatorias.

- Responsabilidad legal y ética: cuando una IA participa en una decisión que causa daño, la distribución de responsabilidades entre desarrolladores, organizaciones sanitarias y profesionales sigue siendo compleja.

- Robustez frente a contexto clínico: la IA puede performar bien en escenarios cerrados (por ejemplo, detección radiológica específica) pero fallar ante comorbilidades, presentaciones atípicas o circunstancias sociales que el clínico capta en la consulta.

Qué aporta la IA y casos comparables

Al mismo tiempo, existen beneficios demostrados que explican el interés por su integración:

- Mejora en eficiencia y triaje: algoritmos de apoyo pueden priorizar imágenes o consultas, reducir tiempos de espera y optimizar rutas de atención.

- Asistencia diagnóstica: herramientas de aprendizaje automático han mostrado utilidad en la detección precoz de ciertos hallazgos en imágenes médicas y en la interpretación de pruebas que consumen mucho tiempo.

- Soporte documental y administrativo: la IA puede automatizar tareas repetitivas como resumen de historias clínicas, lo que libera tiempo clínico.

En la práctica, algunos países han autorizado o pilotado sistemas de IA en radiología, oftalmología o triage digital; estos despliegues suelen incluir condiciones regulatorias, validación clínica y supervisión humana obligatoria. Sin embargo, también hay ejemplos públicos de proyectos ambiciosos que no alcanzaron los resultados esperados por problemas de generalización, integración o gobernanza, lo que refuerza la idea de implementación cautelosa.

Implicaciones para profesionales y recomendaciones prácticas

Para sanitarios y directivos hospitalarios, la declaración del papa subraya la necesidad de integrar la IA como herramienta complementaria y no como sustituto automático. Algunas recomendaciones accionables:

- Adoptar una política de «IA como apoyo con supervisión humana»: cualquier algoritmo que influya en el diagnóstico o tratamiento debería requerir la revisión de un profesional antes de decisiones críticas.

- Evaluación clínica previa a la implementación: realizar estudios de validación local que midan sensibilidad/especificidad, equidad entre subgrupos y efectos en resultados clínicos relevantes.

- Formación continuada: incluir alfabetización en IA en la formación médica y de enfermería para entender limitaciones, sesgos y la interpretación de métricas de rendimiento.

- Gobernanza y comités multidisciplinares: crear comités que incluyan clínicos, ingenieros, bioeticistas y representantes de pacientes para evaluar adquisiciones y monitorizar uso.

- Transparencia y consentimiento informado: informar a los pacientes cuando se usa IA en su atención y documentar cómo influyó en decisiones clínicas.

- Monitoreo post-despliegue: establecer métricas de vigilancia y circuitos para actualizar modelos, corregir sesgos y retirar herramientas que no cumplan expectativas clínicas.

- Planes de responsabilidad y seguros: clarificar responsabilidades legales en caso de errores atribuibles a sistemas automatizados.

Reflexión sobre el futuro: colaboración necesaria entre tecnología y humanismo clínico

Las declaraciones que contrastan la visión utilitarista de la IA con la centralidad del acto médico recuerdan que la medicina es una práctica humana y relacional. Los desarrollos tecnológicos pueden aumentar la capacidad diagnóstica y liberar tiempo para la atención directa al paciente, pero no sustituyen competencias humanas como la ética, la comunicación y la toma de decisiones en contextos complejos.

Para que la IA aporte valor real y seguro, el sector sanitario debe apostar por implementaciones rigurosas, reguladas y orientadas a mejorar resultados de salud medibles. Al mismo tiempo, las instituciones formadoras y las organizaciones profesionales tienen la responsabilidad de preparar a los profesionales para usar estas herramientas con juicio clínico, y para salvaguardar la dignidad y el bienestar del paciente.

Conclusión

La intervención del papa León XIV sintetiza un consenso prudente: la IA es una herramienta poderosa para mejorar la asistencia clínica pero no puede reemplazar elementos humanos esenciales del acto médico. La integración responsable exige validación, gobernanza, formación y supervisión humana continuada. Para profesionales sanitarios y gestores, la prioridad es diseñar procesos que combinen la precisión tecnológica con el cuidado humano —de modo que la IA amplíe capacidades sin deshumanizar la atención.

Source: www.20minutos.es